La IA lo sabe todo de ti: una jurista experta revela los riesgos ocultos para tu privacidad

Desde las aspiradoras hasta los coches autónomos, los sistemas inteligentes recopilan datos sin cesar, pero existen formas de protegerse de esta vigilancia constante

Hablamos sobre IA

Zaragoza - Publicado el - Actualizado

4 min lectura

La extraña sensación de hablar sobre un producto y que, minutos después, aparezca un anuncio sobre él en el móvil es cada vez más común. Esta percepción de ser observados por nuestros dispositivos es una consecuencia directa de la expansión de la inteligencia artificial (IA). Pero, ¿hasta dónde llega esta vigilancia y cuáles son los riesgos reales?

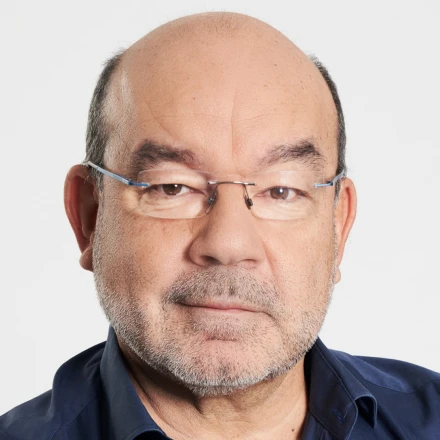

La jurista tecnológica y miembro de Aragón Privacidad, Ana Belén Lord Gallegos, analiza la relación entre IA y privacidad, aclarando que estos sistemas están presentes en casi todos los aspectos de nuestro día a día. Según la experta, la IA ya no solo está en el asistente del móvil o en la aspiradora, sino que se ha convertido en un fenómeno que "alcanza todos los ámbitos de nuestra vida, en la salud, en la educación, en seguridad, en el comercio". Su objetivo principal es "mejorar la productividad y optimizar el tiempo".

¿Dónde se esconde la inteligencia artificial?

Aunque a menudo la asociamos con asistentes virtuales como Siri o Alexa, la IA opera en ámbitos mucho más críticos. Lord Gallegos explica que, en el campo de la educación, se utiliza para crear "sistemas personalizados para los alumnos" que detectan sus debilidades. En sanidad, ya es una herramienta clave para el "diagnóstico de imágenes" y para analizar historiales clínicos. También es fundamental en la gestión de servicios públicos, ya que puede predecir carencias o fallos en el suministro.

Otro de los sectores más visibles es el del transporte, con el auge de los "coches autónomos" como los de Tesla. Estos vehículos "tienen sistemas de inteligencia artificial que detectan el peligro y saben cómo actuar". Y, por supuesto, en el hogar, donde los "asistentes inteligentes" llevan años con nosotros, procesando nuestras peticiones para ofrecer respuestas cada vez más precisas, integrando a veces modelos generativos como ChatGPT sin que tengamos que acceder a la aplicación directamente.

El dilema de la privacidad y las filtraciones

Esta interacción constante tiene un impacto directo en nuestra privacidad. Estamos revelando continuamente detalles personales, hasta el punto de que muchos usuarios sienten que su IA les conoce mejor que ellos mismos. "A veces siento que mi ChatGPT sabe más de mí mismo que yo", reflexiona la experta sobre una sensación común. Aunque podamos desarrollar un cierto "cariño" por estas herramientas, Lord Gallegos advierte de que hay que tener cuidado, ya que "ChatGPT ya ha sufrido filtraciones de datos".

La experta recalca que, si bien en Europa existen normativas como el Reglamento de Protección de Datos que controlan el tratamiento de la información, la seguridad no es infalible. "No nos podemos fiar de que fallen los servidores, que se sufra un ataque, una filtración, y que todo eso se desprenda", avisa. Esto va más allá de las políticas de privacidad y entra en el terreno de la ciberseguridad, donde los datos de los usuarios pueden quedar expuestos, lo que ya ha ocasionado problemas, "sobre todo más que a nivel individual, a nivel empresas".

Esos datos se encuentran recopilados y los pueden utilizar para publicitarte"

Jurista tecnológica y miembro de Aragón Privacidad

Una de las preguntas más recurrentes es si nuestros dispositivos nos escuchan activamente. La jurista es clara: para poder responder a un comando como "Oye, Siri", el aparato debe tener el micrófono constantemente activo. Esto implica que todo lo que decimos es captado. Aunque matiza que no es necesariamente "con intenciones malignas", afirma que "esos datos se encuentran recopilados y los pueden utilizar la empresa para mejorar tus estadísticas, tus respuestas o para publicitarte con ellas".

Claves para proteger tu intimidad digital

Ante esta realidad, Ana Belén Lord Gallegos ofrece una serie de recomendaciones prácticas para proteger nuestra privacidad sin renunciar por completo a las ventajas de la IA. El primer paso es gestionar los términos de uso y no aceptar todo de forma automática. "En Europa, por ley, es obligatorio tener la opción de no aceptar cookies o las políticas de privacidad", recuerda. También es crucial desactivar la activación por voz constante en aplicaciones como ChatGPT y encenderla solo cuando la vayamos a usar.

Otra clave fundamental es "compartir la información sensible lo menos posible". Esto incluye no facilitar datos bancarios, direcciones o información confidencial de empresas. Además, la experta subraya la importancia de ser críticos con las respuestas que nos da la IA, pues no siempre son fiables. Alerta sobre los "sesgos" en la información y el fenómeno de las "alucinaciones", que se produce cuando la IA "se inventa datos" por no haber procesado correctamente la información.

La IA es una herramienta, pero no es la solución a la vida"

Jurista tecnológica y miembro de Aragón Privacidad

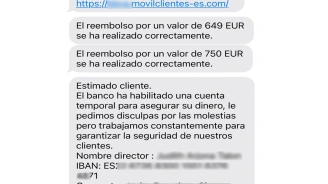

Por ello, es imprescindible contrastar siempre la información que nos facilita. Lord Gallegos señala que ChatGPT "siempre te va a decir que todo es perfecto y que todo está bien", pero debemos coger sus respuestas con pinzas y "contrastarla" en la medida de lo posible. También advierte del riesgo de clicar en enlaces ofrecidos por la IA sin verificarlos, pues podrían dirigir a páginas maliciosas. El mensaje final es claro: "La IA es una herramienta, pero no es la solución a la vida".

Finalmente, la experta insiste en que la inteligencia artificial es un apoyo, no un sustituto del trabajo humano. En áreas como los recursos humanos, puede ayudar a "seleccionar perfiles", pero estos deben ser siempre "revisados por una persona humana". El riesgo es especialmente alto en el entorno empresarial, donde una fuga de datos por un mal uso de la IA por parte de los empleados puede tener consecuencias económicas devastadoras. Por ello, concluye que es fundamental que tanto empresas como empleados reciban "formación adecuada" para usar estos sistemas de forma segura y ética.

Este contenido ha sido creado por el equipo editorial con la asistencia de herramientas de IA.