Ya existe un modelo de Inteligencia Artificial que evita sesgos en áreas clave como salud, educación y contratación: “No discriminar”

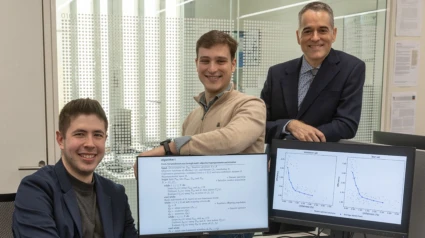

El estudiante Alberto García y el responsable de la investigación Rubén Armañanzas explican el desarrollo de esta IA en Cope Navarra

Una inteligencia que no discrimine, sin sesgos de edad, sexo y etnia. / UNAV

Pamplona - Publicado el - Actualizado

5 min lectura16:06 min escucha

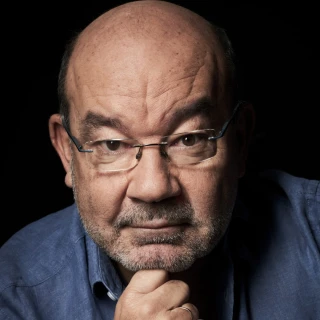

Humberto Bustince, catedrático de la UPNA y profesor del departamento de Ciencia de la Computación e Inteligencia Artificial, leía ayer el pregón de la XXV edición del día de la Tostada y la XX de la Orden de la Oliva. Un discurso centrado precisamente en la Inteligencia Artificial. Sin duda, una tecnología que está cambiando el mundo.

Una de las áreas que la IA va a revolucionar es el área de la salud, de la sanidad. La IA artificial va ayudar a los médicos a tener y almacenar más información de manera más rápida y sencilla. Pero además, va a tener la ayuda de la IA para tener un diagnóstico. Humberto Bustince explicaba esto en los micrófonos de Cope Navarra. “Cada médico no va a tener que escribir el historial, sino que lo va a hablar y le va a permitir atender a más pacientes”. La primera aplicación de la IA va a ir, por tanto, a ayudar en la gestión.

Sin embargo, también es una herramienta muy importante para “poder predecir información”. Según Bustince, es “fundamental en todo”. Desde la neurociencia computacional hasta la detección de determinados tipos de cáncer. “Es cierto que tardará más tiempo en llegar a los médicos, pero en todo lo que es radiología y radioterapia es un avance impresionante”.

Sin embargo, este tipo de inteligencia tiene, todavía, varios riesgos. La ayuda es muy importante, pero no puede sustituir al médico, desde luego. Uno de los riesgos es que la IA artificial te da una información que puede ser muy valiosa, pero no te da una explicación de por qué hay que hacer las cosas.

Otro de los grandes peligros que tiene la inteligencia artificial son los sesgos. En el fondo se basan en mucha información que ya está publicada y que tiene ya muchos sesgos de los seres humanos. Lo explica Joaquín Sevilla, físico y catedrático de la UPNA. “Las inteligencias artificiales están entrenadas con conjuntos de gatos humanos, donde se reflejan los sesgos que tenemos los humanos. Muchos de esos sesgos, aunque cuando los analizas y los identificas, no te gusta tenerlos, lo cierto es que se han generado porque resultaban evolutivos de alguna manera.”

Por ello, Humberto Bustince asegura que hay que legislar sobre la IA. Y estamos muy lejos de tener una buena legislación que nos ampare ante todo lo que la IA es capaz de llegar. “La legislación se queda totalmente corta. Yo puedo educar a un sistema totalmente racista. Pierdes privacidad y además puedes generar sistemas totalmente sesgados, de homófobos, racistas, de lo que les dé la gana. Hay dos gigantes que son Estados Unidos y China que deciden todo lo que quiera. En Europa se está intentando poner equilibrio, pero estamos perdiendo la batalla”.

Proyecto de ia no discriminatoria de la un

En Cope Navarra, hemos a hablar de uno de estos proyectos que pretende mejorar la equidad y confiabilidad de los modelos de inteligencia artificial utilizados en la toma de decisiones críticas, como puede ser la salud.

El equipo, formado por los investigadores Alberto García Galindo, Marcos López De Castro y Rubén Armañanzas Arnedillo, ha desarrollado un nuevo sistema que optimiza los parámetros de modelos de aprendizaje automático confiables. Estos modelos son algoritmos de IA que realizan predicciones de una manera transparente asegurando ciertos niveles de confianza. Con esta contribución, los investigadores proponen una metodología capaz de reducir las desigualdades relacionadas con atributos sensibles como la raza, el género o el nivel socioeconómico, entre otros. Evitar ciertos sesgos.

La meta es desarrollar una IA que no discrimine en función de sexo, edad o etnia. Alberto García. “Abordamos el desarrollo de una inteligencia artificial que no solo trabaje para que los modelos sean precisos, que que bien, sino que toda esta parte desde el punto de vista de la aplicación se realice desde un punto de vista. En nuestro caso, lo abordamos desde el punto de vista de la no discriminación”. No discriminación, en este caso, por etnia, edad o sexo.

Alberto García, ha puesto el ejemplo de una inteligencia artificial que ayuda a la justicia en Estados Unidos. Estudiando ese ejemplo, se han dado cuenta de que tiene un sesgo importante: predecía una mayor predisposición a la reincidencia criminal a las personas afroamericanas que a las caucásicas. Y la realidad era distinta.

Pero preparar a la IA a que tenga estos valores, a que gestione estos sesgos, a que no discrminie por edad, sexo o etnia, no es fácil. “Ajustar esos parámetros y esa detección de patrones. No hay que tener en cuenta únicamente que el modelo sea preciso, sino que hay que cuantificar cuál es esa desviación entre esos grupos demográficos que nosotros planteamos en base a estos atributos de los que hablábamos: razas, sexualidad o edad. Y en el momento de optimizar esos parámetros, que el modelo de por sí haga una exploración de cuáles son esas configuraciones de parámetros que no me van a comprometer la equidad de algoritmo”.

Rubén Armañanzas ha querido recordar que, aunque la máquina o el algoritmo es muy potente, lo cierto es que el verdadero poder lo tiene el diseñador. Quien diseña esa IA con ciertos parámetros. “Quien está a los mandos de estas correcciones es el diseñador, no es el algoritmo. El algoritmo no deja de ser un conjunto de reglas, unas operaciones de matemática avanzada que nos llevan a un modelo. Es el diseñador el que tiene que decir este es mi atributo problemático, este es mi grupo desprotegido y quiero corregirlo”.